Autovettore e autovalore

In matematica, in particolare in algebra lineare, un autovettore di una funzione tra spazi vettoriali è un vettore non nullo la cui immagine è il vettore stesso moltiplicato per uno scalare detto autovalore.[1] Se la funzione è lineare, gli autovettori aventi in comune lo stesso autovalore, insieme con il vettore nullo, formano uno spazio vettoriale, detto autospazio.[2] La nozione di autovettore viene generalizzata dal concetto di vettore radicale o autovettore generalizzato.

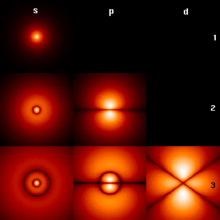

I concetti di autovettore e autovalore sono utilizzati in molti settori della matematica e della fisica; il problema della ricerca degli autovalori di una funzione lineare corrisponde alla sua diagonalizzazione. Se un autovettore è una funzione, si parla di autofunzione; per esempio in meccanica classica è molto comune considerare la funzione esponenziale come autofunzione della derivata. Formalismi di questo tipo consentono di descrivere molti problemi relativi ad un sistema fisico: ad esempio, i modi di vibrazione di un corpo rigido o i livelli energetici degli orbitali atomici e molecolari sono associati ad autovettori (autostati) di funzioni (osservabili) che ne determinano la dinamica.

Il termine autovettore è stato tradotto dalla parola tedesca Eigenvektor, coniata da David Hilbert nel 1904. Eigen significa "proprio", "caratteristico". Analogamente il prefisso auto- usato nella versione italiana non è abbreviazione di "automatico", bensì è preso dal greco autós con significato "di sé stesso". Nella letteratura italiana si trova spesso l'autovettore indicato come vettore proprio, vettore caratteristico o vettore latente.

Introduzione informale

[modifica | modifica wikitesto]

Il piano cartesiano e lo spazio euclideo sono esempi particolari di spazi vettoriali: ogni punto dello spazio può essere descritto tramite un vettore, rappresentato graficamente da un segmento che collega l'origine al punto. In uno spazio vettoriale è possibile effettuare trasformazioni lineari sui vettori che lo costituiscono: esempi di trasformazioni lineari sono le rotazioni, le omotetie (che consentono a un vettore di essere amplificato o contratto) e le riflessioni (che consentono a un vettore di essere trasformato nel suo speculare rispetto a un punto, retta o piano assegnati).

Un autovettore per la trasformazione lineare è un vettore che a seguito dell'applicazione di non cambia la sua direzione, limitandosi ad essere moltiplicato per uno scalare , il rispettivo autovalore. Il vettore può quindi soltanto cambiare modulo (venendo amplificato o contratto) e verso (venendo ribaltato):

- se il verso di rimane inalterato, mentre se il verso di cambia

- se il modulo di rimane inalterato, se il modulo cresce, se decresce.

Autovettori e autovalori sono definiti e usati in matematica e fisica nell'ambito di spazi vettoriali più complessi e astratti di quello tridimensionale della fisica classica. Questi spazi possono avere dimensione maggiore di 3 o addirittura infinita (un esempio è dato dallo spazio di Hilbert). Anche le possibili posizioni di una corda vibrante in una chitarra formano uno spazio di questo tipo: una vibrazione della corda è quindi interpretata come trasformazione di questo spazio e i suoi autovettori (più precisamente, le sue autofunzioni) sono le onde stazionarie.

Definizione

[modifica | modifica wikitesto]Sia uno spazio vettoriale su un campo , che può essere ad esempio il campo dei numeri reali o il campo dei complessi . Sia un endomorfismo di , cioè una trasformazione lineare:

Se è un vettore non nullo in e è uno scalare tali che:

allora è un autovettore della trasformazione , e è il suo autovalore.[1]

Poiché è lineare, se è un autovettore con autovalore , allora ogni multiplo non-nullo di è anch'esso un autovettore con lo stesso autovalore . Infatti, detto un qualsiasi vettore tale che , con , si avrà poiché è lineare. Ma essendo , si ha che:

cioè .

Più in generale, gli autovettori aventi lo stesso fissato autovalore , insieme al vettore nullo, generano un sottospazio di chiamato l'autospazio relativo all'autovalore , solitamente indicato con .[2]

Lo spettro di è l'insieme dei suoi autovalori. Il raggio spettrale di è l'estremo superiore dei moduli dei suoi autovalori.

Descrizione matriciale e autovettore sinistro

[modifica | modifica wikitesto]Nel caso in cui sia di dimensione finita, per ogni scelta di basi a è associata univocamente una matrice, detta matrice di trasformazione.[3] Si può pertanto parlare di una funzione lineare sia in termini di funzione (trasformazione) che di matrice, ed il formalismo matriciale viene spesso utilizzato per la ricerca di autovettori e autovalori.

Sia il vettore delle coordinate di rispetto a una base e sia la matrice di trasformazione rappresentante rispetto alla medesima base. Si ha che è detto autovettore di se esiste uno scalare detto autovalore tale che:[4]

In particolare, gli autovalori di non dipendono dalla base scelta.

Il vettore è detto autovettore destro, in quanto un vettore non nullo è detto autovettore sinistro se esiste tale che:[5]

dove è il vettore trasposto complesso coniugato di . Se è autovettore sinistro di con autovalore , allora è anche autovettore destro della matrice trasposta coniugata con autovalore il complesso coniugato .

Senza ulteriori precisazioni, per "autovettore" si intende l'autovettore destro.

Autofunzioni

[modifica | modifica wikitesto]Spesso gli autovettori sono a loro volta funzioni, e in tal caso si parla di autofunzioni di un operatore. Un esempio molto significativo in matematica e fisica è quello dell'autofunzione:

dell'operatore differenziale derivata:

a cui corrisponde l'autovalore in quanto:

Polinomio caratteristico

[modifica | modifica wikitesto]Si definisce polinomio caratteristico nella variabile associato a una matrice quadrata il determinante:[6]

dove è la matrice identità con lo stesso numero di righe di . Le radici del polinomio caratteristico sono tutti gli autovalori di .[7]

Due matrici che rappresentano un endomorfismo di uno spazio vettoriale a dimensione finita sono simili, e in particolare hanno il medesimo polinomio caratteristico, e dunque gli stessi autovalori. Si tratta di uno strumento di grande importanza, che ha permesso di sviluppare un metodo generale per l'individuazione di autovalori e autovettori di un endomorfismo nel caso in cui lo spazio vettoriale abbia dimensione finita.[8]

Il polinomio permette inoltre di stabilire l'esistenza di autovalori e autovettori per un'applicazione lineare:

- Il polinomio caratteristico di ha grado , e quindi ha al più radici: segue che ha al più autovalori distinti.

- Se è algebricamente chiuso allora il polinomio caratteristico ha sempre almeno una radice: segue che ha almeno un autovalore, e quindi anche almeno un autovettore.[9] Nel caso reale questo non succede sempre, ad esempio si possono trovare autovalori complessi.

- Se la dimensione di è dispari e è il campo dei numeri reali, il polinomio caratteristico ha grado dispari, e quindi ha sempre almeno una radice reale. Ad esempio, ogni endomorfismo di ha almeno un autovettore.

- Inoltre se il polinomio caratteristico di è completamente fattorizzabile allora è triangolabile, ossia esiste base di tale per cui la matrice associata è una matrice triangolare.

Diagonalizzabilità

[modifica | modifica wikitesto]Sia un endomorfismo di uno spazio vettoriale , cioè una trasformazione lineare . Si dice che è diagonalizzabile se esiste una base di rispetto alla quale la matrice che rappresenta è diagonale.[10] In particolare, la base che diagonalizza è composta da suoi autovettori.

In modo equivalente, una matrice quadrata è diagonalizzabile se è simile a una matrice diagonale.[11] La matrice è quindi diagonalizzabile nel campo di appartenenza se esiste una matrice invertibile tale che:

ossia:

Scrivendo in termini dei vettori colonna:

La precedente relazione diventa:

I vettori colonna di sono dunque autovettori di , e i corrispondenti elementi della matrice diagonale sono i rispettivi autovalori. L'invertibilità di implica inoltre l'indipendenza lineare degli autovettori, che formano una base dello spazio.

Il teorema spettrale

[modifica | modifica wikitesto]Nel caso complesso finito-dimensionale il teorema spettrale afferma che l'endomorfismo è normale se e solo se esiste una base ortonormale di fatta di suoi autovettori.[12] In tal caso la matrice è unitaria. Questo fondamentale risultato fornisce le condizioni per cui sia possibile diagonalizzare un operatore lineare rispetto a una base ortonormale: nel caso finito-dimensionale, quando questo risulta possibile succede che ad autovalori distinti corrispondono autovettori mutuamente ortogonali, e pertanto gli autospazi sono in somma diretta.

La decomposizione spettrale è un caso particolare della decomposizione di Schur. È anche un caso particolare della decomposizione ai valori singolari. Un operatore normale può, di conseguenza, essere scritto come una combinazione lineare di proiettori ortogonali sugli autospazi, i cui coefficienti sono gli autovalori relativi a ogni autospazio.

Nel caso infinito-dimensionale la normalità, e in particolare l'autoaggiuntezza, non garantisce la diagonalizzabilità. In generale un operatore normale non può essere più scritto come combinazione lineare di proiettori ortogonali. Tuttavia, attraverso una misura a valori di proiettore è possibile ottenere una scrittura integrale che permette di descrivere l'operatore in termini del suo spettro.

Spettro di un operatore

[modifica | modifica wikitesto]In uno spazio di dimensione infinita la definizione di autovalore è identica al caso di dimensione finita. Tuttavia, il polinomio caratteristico non è uno strumento disponibile in questo caso in quanto si rende necessario considerare ulteriori elementi dello spettro.

Sia un operatore lineare limitato definito su uno spazio di Banach complesso . Si definisce insieme risolvente di l'insieme dei numeri complessi tali per cui l'operatore è invertibile, ovvero ha un inverso che è un operatore lineare limitato. Si definisce risolvente di la funzione:

Lo spettro di è l'insieme dei numeri complessi che non appartengono all'insieme risolvente, ovvero tali per cui l'operatore non è invertibile.[13]

Dal momento che è un operatore lineare, se il suo inverso esiste esso è lineare. Inoltre, per il teorema del grafico chiuso l'inverso di un operatore lineare limitato è limitato. Segue che l'insieme risolvente è l'insieme dei valori che rendono bigettivo.

Lo spettro di un operatore non può essere vuoto, e si possono distinguere tre suoi sottoinsiemi disgiunti:

- Si definisce spettro puntuale o discreto di l'insieme degli autovalori di , ovvero i numeri complessi tali che:

- Gli autovalori sono quindi i numeri tali per cui , ossia : la funzione non è invertibile se il suo nucleo non è costituito dal solo vettore nullo, ovvero esistono dei vettori tali per cui esiste un tale che . In modo equivalente, è autovalore di se e solo se non è iniettivo, oppure se e solo se .

- Si definisce spettro continuo di l'insieme dei numeri tali per cui non è limitato, pur essendo densamente definito.

- Si definisce spettro residuo di l'insieme dei numeri che non sono autovalori e tali per cui l'operatore non ha immagine densa in .[14]

Operatori aggiunti e autoaggiunti

[modifica | modifica wikitesto]La definizione di operatore aggiunto si diversifica a seconda che ci si trovi in uno spazio di Hilbert o in uno spazio di Banach. A causa di ciò, lo spettro di un operatore definito su uno spazio di Banach coincide con quello del suo aggiunto, mentre in uno spazio di Hilbert, denotando l'aggiunto di con , si ha che:

Inoltre, se appartiene allo spettro residuo di , allora appartiene allo spettro puntuale dell'aggiunto . Se invece appartiene allo spettro puntuale di , allora esso appartiene sia allo spettro puntuale e sia allo spettro residuo di .[15]

Se è autoaggiunto su uno spazio di Hilbert, si ha inoltre:

- non ha spettro residuo.

- è un sottoinsieme di , ossia gli autovalori sono reali.

- Autovettori relativi ad autovalori distinti sono ortogonali.

Applicazioni

[modifica | modifica wikitesto]Lo studio degli autovalori e autovettori relativi a una trasformazione lineare, che consiste nell'autoteoria, è una delle problematiche principali affrontate dall'algebra lineare, e ha vastissime applicazioni in diversi ambiti della scienza.

Operatori in meccanica quantistica

[modifica | modifica wikitesto]

In meccanica quantistica ad un vettore (detto in tale contesto autoket) si associa uno "stato" o autostato dell'oggetto considerato. In termini informali, per evidenziare il fatto che in generale non si conosce questo stato, lo si descrive come una combinazione lineare (o sovrapposizione) di autovettori (autostati) noti di un qualche operatore. L'operatore in questione "rappresenta" una certa osservabile, alla quale corrisponde una grandezza fisica: ad esempio l'operatore hamiltoniano è associato all'energia dell'oggetto. Se si sceglie di scrivere lo stato dell'oggetto tramite una combinazione lineare di autovettori di , a ogni autovettore è associato un possibile valore dell'energia dell'oggetto, che è il relativo autovalore:

Una tale rappresentazione matriciale dell'equazione di Schrödinger indipendente dal tempo è possibile se, come spesso accade (ad esempio studiando gli stati legati), è una funzione quadrato sommabile: tali funzioni formano uno spazio di Hilbert infinito-dimensionale con prodotto interno .

L'operazione che tramite l'applicazione di restituisce uno degli autovalori è detta misura, e fa "collassare" o "precipitare" lo stato dell'oggetto in un autostato dell'osservabile che si sta misurando. La misura altera irrimediabilmente lo stato del sistema, che viene a trovarsi in un autostato ben preciso. L'insieme dei valori (autovalori) possibili per la misura di una grandezza osservabile è lo spettro dell'operatore ad essa associato. Dovendo quantificare una grandezza fisica, è inoltre necessario che sia un operatore hermitiano: in questo modo gli autovalori sono tutti reali, e i suoi autostati (normalizzati) formano una base ortonormale dello spazio. Grazie al prodotto interno è possibile proiettare l'autostato sulla una base di autostati di un altro operatore, come la base di autovettori dell'operatore posizione. La proiezione:

definisce la funzione d'onda , una descrizione probabilistica della posizione dell'oggetto. La funzione d'onda è dunque un'autofunzione di corrispondente all'autovalore :

Il prodotto interno nello spazio di Hilbert è inoltre dato da:

dove indica la coniugazione complessa. Questo limita la possibilità di scelta dello spazio di Hilbert allo spazio delle funzioni a quadrato integrabile sul dominio scelto , che può al limite essere tutto .

Teoria dei numeri

[modifica | modifica wikitesto]Lo studio degli autovalori di una matrice ha importanti applicazioni anche nella teoria dei numeri. In particolare, si congettura che alcune statistiche sugli zeri non banali della funzione zeta di Riemann, quali ad esempio quelle sulla distanza tra zeri consecutivi, siano le stesse di quelle relative alle matrici hermitiane aleatorie (rispetto alla misura di Haar) di dimensione al tendere di all'infinito. Inoltre, è stato congetturato che anche la distribuzione dei valori della funzione zeta di Riemann sia ben approssimata, in media, dai valori assunti dal polinomio caratteristico di tali matrici. Analoghe considerazioni si possono fare su altre famiglie di funzioni speciali, quali ad esempio le funzioni L di Dirichlet, coinvolgendo anche altre famiglie di matrici aleatorie, come ad esempio le matrici simplettiche o ortogonali. Tale connessione ha avuto come risultato un fiorire di una serie di nuove congetture in teoria dei numeri.[16]

Autofacce

[modifica | modifica wikitesto]

Nella elaborazione digitale delle immagini, le immagini di facce possono essere viste come vettori le cui componenti sono la luminosità dei singoli pixel.[17] La dimensione dello spazio vettoriale in cui sono ambientati è pari al numero di pixel, e gli autovettori di una particolare matrice, detta matrice di covarianza, sono chiamati autofacce. Essi sono molto utili per esprimere ogni faccia come una combinazione lineare di queste autofacce, e sono quindi anche un ottimo strumento di compressione dei dati per memorizzare e identificare un alto numero di facce.

Tensore d'inerzia

[modifica | modifica wikitesto]In meccanica, gli autovettori del tensore di inerzia definiscono gli assi principali di un corpo rigido. Il tensore di inerzia è una quantità chiave, necessaria per determinare la rotazione di un corpo rigido intorno al suo baricentro. Gli autovettori del tensore delle deformazioni definiscono gli assi principali di deformazione.

Esempi

[modifica | modifica wikitesto]Esempi nel piano

[modifica | modifica wikitesto]Fra le trasformazioni del piano cartesiano si possono distinguere i seguenti casi speciali:

- Rotazione antioraria di angolo . Se non è un multiplo intero di non esiste alcun autovettore, infatti ogni vettore viene ruotato e cambia di direzione. Se invece , con intero dispari, ogni vettore viene trasformato nel suo opposto, quindi ogni vettore non nullo è autovettore della rotazione con autovalore . Se invece è pari la trasformazione non è altro che l'identità, per cui ogni vettore non nullo è autovettore con autovalore .

- La rotazione può essere rappresentata dalla seguente matrice:

- Riflessione rispetto a una retta passante per l'origine. I vettori in restano fermi e sono quindi autovettori con autovalore , mentre quelli della retta perpendicolare a e passante per l'origine vengono ribaltati, e quindi sono autovettori con autovalore . Non esistono altri autovettori.

- La riflessione, nel caso di retta r orizzontale, può essere rappresentata dalla seguente matrice:

- Omotetia. Ogni vettore viene moltiplicato per uno scalare e quindi tutti i vettori non nulli sono autovettori con autovalore .

- L'omotetia può essere rappresentata dalla seguente matrice:

- Proiezione ortogonale su una retta passante per l'origine. I vettori su restano fermi e quindi sono autovettori con autovalore , mentre i vettori sulla retta ortogonale a e passante per l'origine sono mappati tutti sull'origine e quindi sono autovettori con autovalore . Non ci sono altri autovettori.

- La proiezione ortogonale può essere rappresentata dalla seguente matrice:

Esempi nello spazio

[modifica | modifica wikitesto]Non tutte le trasformazioni del piano e dello spazio ricadono in una delle 4 tipologie viste negli esempi del piano sopra riportate.

In generale, un endomorfismo di (cioè una trasformazione lineare di in sé) è rappresentabile tramite una matrice quadrata con n righe. Si consideri per esempio l'endomorfismo di indotto dalla matrice:

Se si considera il vettore :

e si esegue la moltiplicazione fra matrice e vettore, si vede che:

Quindi l'endomorfismo rappresentato da ha un autovettore dato da con autovalore 2. Per trovarne tutti gli autovalori si deve scrivere il polinomio caratteristico di . Poiché la trasformazione è già scritta in forma di matrice, si procede con il calcolarne il polinomio caratteristico:

Quindi gli autovalori di sono 2, 1 e −1. I tre autovettori ortogonali sono:

Per quanto detto prima, la trasformazione assume una forma molto semplice rispetto a questa base: ogni vettore in può essere scritto in modo unico come:

e dunque si ha:

Data infine una trasformazione lineare , si è visto che se il polinomio caratteristico di ha tutte le radici in con molteplicità 1, allora è diagonalizzabile. Se invece il polinomio caratteristico di ha tutte le radici in ma alcune di esse hanno molteplicità maggiore di 1, allora non è necessariamente diagonalizzabile. Ad esempio la matrice:

che rappresenta la trasformazione della Gioconda in figura ha come polinomio caratteristico , e non è diagonalizzabile per .

Esempi di calcolo

[modifica | modifica wikitesto]Data la matrice di trasformazione:

il vettore:

è un autovettore con autovalore 2. Infatti:

Per contro il vettore:

non è un autovettore in quanto il vettore trasformato è:

e, come si nota facilmente, manca la proporzionalità tra il vettore trasformato e il vettore originale , condizione necessaria per il parallelismo.

Come secondo esempio, si consideri la matrice di trasformazione:

è facile verificare che i vettori:

sono autovettori con autovalori 3 e 1 rispettivamente.

Note

[modifica | modifica wikitesto]- ^ a b S. Lang, Pag. 220.

- ^ a b S. Lang, Pag. 221.

- ^ S. Lang, Pag. 104.

- ^ S. Lang, Pag. 105.

- ^ Jim Lambers - The Unsymmetric Eigenvalue Problem

- ^ S. Lang, Pag. 227.

- ^ S. Lang, Pag. 228.

- ^ Nella pratica gli autovalori di grandi matrici non vengono calcolati usando il polinomio caratteristico, esistendo metodi numerici più veloci e sufficientemente stabili.

- ^ S. Lang, Pag. 223.

- ^ S. Lang, Pag. 114.

- ^ S. Lang, Pag. 115.

- ^ S. Lang, Pag. 251.

- ^ Reed, Simon, Pag. 188.

- ^ Lo shift unilaterale su ne fornisce un esempio: tale operatore è una isometria, ed è quindi limitato ma non invertibile poiché non è surriettivo.

- ^ Reed, Simon, Pag. 194.

- ^ (EN) John Keating, L-functions and the Characteristic Polynomials of Random Matrices, in Francesco Mezzadri e Nina Snaith (a cura di), Recent perspectives in random matrix theory and number theory, Cambridge, Cambridge University Press, 2005, pp. 251-278, ISBN 978-0-521-62058-1.

- ^ A. Xirouhakis, G. Votsis e A. Delopoulus, Estimation of 3D motion and structure of human faces (PDF), Online paper in PDF format, National Technical University of Athens, 2004.

Bibliografia

[modifica | modifica wikitesto]- Serge Lang, Algebra lineare, Torino, Bollati Boringhieri, 1992, ISBN 88-339-5035-2.

- (EN) Michael Reed, Barry Simon, Methods of Modern Mathematical Physics, Vol. 1: Functional Analysis, 2ª ed., San Diego, California, Academic press inc., 1980, ISBN 0-12-585050-6.

- Marius Stoka, Corso di geometria, Cedam, 1995, ISBN 978-88-13-19192-4.

- (EN) Serge Lang, Algebra, 3rd edition, Springer, 2002, ISBN 0-387-95385-X.

- (EN) Steven Roman, Advanced Linear Algebra, Springer, 1992, ISBN 0-387-97837-2.

- (EN) Paul R. Halmos, Finite-dimensional Vector Spaces, Springer, 1993, ISBN 0-387-90093-4.

- (EN) Werner H. Greub, Linear Algebra, 4th ed., Springer, 1981, ISBN 0-387-90110-8.

- (EN) Jim Hefferon, Linear Algebra, Online book, St Michael's College, Colchester, Vermont, USA 2001.

- (EN) Gene H. Golub e Charles F. van Loan, Matrix computations, 3rd Edition, Johns Hopkins University Press, 1996, ISBN 0-8018-5414-8.

- (EN) Nelson Dunford e Jacob Schwartz, Linear Operator. Part I General Theory, Wiley-Interscience, 1958, ISBN 0-471-60848-3.

- (EN) V. G. Prikazchikov, Eigen values of differential operators, numerical methods. accessibile in Encyclopaedia of Mathematics

- (EN) A. B. Bakushinskii, Eigen values of integral operators, numerical methods.accessibile in Encyclopaedia of Mathematics

- (EN) Leonid V. Kantorovič e G. P. Akilov, Functional analysis, Pergamon Press, 1982, ISBN 978-14-83-11532-0.

Voci correlate

[modifica | modifica wikitesto]- Autofunzione

- Autostato

- Decomposizione ai valori singolari

- Decomposizione di Schur

- Diagonalizzabilità

- Forma canonica di Jordan

- Polinomio caratteristico

- Raggio spettrale

- Similitudine fra matrici

- Spettro (matematica)

- Teorema spettrale

- Teoremi di Gerschgorin

- Teorema di Schur-Horn

- Trasformazione lineare

- Valore singolare

- Metodo delle potenze inverse: metodo numerico per trovare gli autovalori

Altri progetti

[modifica | modifica wikitesto] Wikizionario contiene il lemma di dizionario «autovettore»

Wikizionario contiene il lemma di dizionario «autovettore»

Wikizionario contiene il lemma di dizionario «autovalore»

Wikizionario contiene il lemma di dizionario «autovalore» Wikiversità contiene risorse su autovettore e autovalore

Wikiversità contiene risorse su autovettore e autovalore

Collegamenti esterni

[modifica | modifica wikitesto]- autovalore, in Enciclopedia della Matematica, Istituto dell'Enciclopedia Italiana, 2013.

- (EN) Eigen vector / Root vector, su Encyclopaedia of Mathematics, Springer e European Mathematical Society.

- Calcolatrici online

- Calculator for Eigenvalues nel sito di Arndt Brünner

- Online Matrix Calculator presso BlueBit Software

- Matrix calculator in WIMS, WWW Interactive Multipurpose Server, presso l'Université Nice Sophia Antipolis

| Controllo di autorità | LCCN (EN) sh85041390 · GND (DE) 4013802-1 · J9U (EN, HE) 987007533688705171 |

|---|

![{\displaystyle {\bigl [}{\begin{smallmatrix}2&1\\1&2\end{smallmatrix}}{\bigr ]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dcacd8bee0f5c4d9f5e8e3fc2c4932447e0e2aec)

![{\displaystyle \scriptstyle v_{1}={\bigl [}{\begin{smallmatrix}1\\1\end{smallmatrix}}{\bigr ]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/bd908778998b9669d6445cb12db4b536980773cf)

![{\displaystyle \scriptstyle v_{2}={\bigl [}{\begin{smallmatrix}1\\-1\end{smallmatrix}}{\bigr ]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a8a589d0af0fe7a4c60324da3be799b8a15aa856)

![{\displaystyle {\bigl [}{\begin{smallmatrix}1\\3\end{smallmatrix}}{\bigr ]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/dc342fe475c1f3e16d616bda8753bd64e6c9e34a)

![{\displaystyle {\bigl [}{\begin{smallmatrix}0\\1\end{smallmatrix}}{\bigr ]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6eacfd7e23aaf01c0ae72792d11542f24451804c)