Scomposizione della devianza

La scomposizione della devianza è un'operazione utilizzata in statistica per calcolare, tra le altre cose, il coefficiente di determinazione e la statistica test ANOVA. Data una variabile numerica si chiama devianza la somma degli scarti quadratici dalla media campionaria ; questa quantità si può scomporre in una parte "spiegata" da una o più variabili e una parte "residua"; la somma di queste due parti è costante e corrisponde alla devianza totale.

Devianza tra e entro gruppi[modifica | modifica wikitesto]

Quando si dispone di gruppi distinti di osservazioni ciascuno di una variabile numerica , si può calcolare la devianza complessiva di ignorando la distinzione tra gruppi, e la si può scomporre in due quantità SSW (devianza entro gruppi, in inglese Sum of Squares Within) e SSB (devianza tra gruppi, in inglese Sum of Squares Between):

- la media campionaria di nel j-esimo gruppo si indica come ;

- la devianza di entro il j-esimo gruppo si indica come ;

- la media campionaria generale di si indica come , e la devianza totale di si indica come ;

- ;

- ;

- .

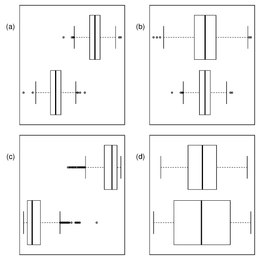

La devianza tra gruppi sarà maggiore di quella entro gruppi quando i valori di sono ben distinti tra gruppi diversi, e sarà invece bassa quando le medie locali si assomigliano. Nel caso limite in cui esse siano tutte uguali, . Questa scomposizione si può usare per creare il coefficiente , che indica la proporzione della devianza totale di che nasce dall'eterogeneità dei gruppi sui quali la variabile viene osservata[1]. In virtù della relazione tra devianza e varianza, introducendo i propri denominatori alle equazioni sopra, si ricava la scomposizione della varianza, la quale ha il vantaggio di ricondurre le quantità empiriche sopra alle proprietà della variabile casuale e permette di condurre i test delle ipotesi che vanno sotto il nome di ANOVA (ANalisys Of VAriance).

Devianza spiegata e residua[modifica | modifica wikitesto]

Quando si dispone di due variabili numeriche e , si può analizzare la relazione tra le due variabili con un modello lineare semplice, in questo modo, per misurare l'associazione tra le due variabili, si può scomporre la devianza totale di (la variabile usata come outcome nel modello lineare) in devianza residua SSR e spiegata SSM (Sum of Squares of Model):

- si indica con il valore di previsto dal modello;

- ;

- .

Il rapporto tra SSM e devianza totale di SST dà luogo al coefficiente di determinazione , il quale è anche il quadrato del coefficiente di correlazione di Pearson . Come si può notare dalle equazioni, è tanto maggiore quando i valori di risultano vicini a quelli previsti del modello, mentre diminuisce quando il modello prevede valori molto vicini tra loro nella scala della .

Chiaramente, questo metodo è facilmente estendibile a un numero maggiore di variabili utilizzando una regressione multivariata, in tal caso il coefficiente perde il suo valore di indice di associazione tra variabili e si volge ad indicare la capacità del modello lineare di determinare appunto il valore di ciascuna osservata, o, in altre parole, la capacità del modello di "spiegare" appunto la variabilità di ; si definisce invece "residua" la devianza (e la rispettiva varianza) di che il modello non riesce a spiegare per mezzo dei predittori .

Si può verificare facilmente che nel caso di una sola variabile esplicativa categorica, i gruppi definiti dalle categorie di quella variabile danno luogo alle equazioni e , perciò .

Note[modifica | modifica wikitesto]

- ^ Amalia Caputo, Relazione tra una variabile categoriale e una cardinale, su federica.unina.it. URL consultato il 9 dicembre 2019.